Künstliche Intelligenz wird oft als Lösung für jede Art von Problemstellung betrachtet. Doch was kann KI in einer komplexen Welt wirklich? Anhand des Einsatzes von KI in der Erkennung von Hassrede und als Lügendetektor an den EU-Außengrenzen werden grundlegende Zweifel an der Funktionalität von KI-Anwendungen exemplarisch dargestellt.

Die Erwartungen an Künstliche Intelligenz (KI) zur Lösung komplexer gesellschaftlicher Probleme sind hoch. Die damit verbundenen Risiken sind bekannt: von Bias und Intransparenz bis hin zur potenziellen Unkontrollierbarkeit einer zukünftigen Superintelligenz. Zu selten wird aber die Frage gestellt: Was kann KI überhaupt und was nicht? Und wie stellt man dies fest? Aus sozialwissenschaftlicher Perspektive sind gesellschaftliche Probleme oft kaum quantifizierbar und ihre Lösungen folgen nicht einfachen Schemata. So setzt beispielsweise die Entwicklung von KI in den Bereichen Asyl, Migration und Strafverfolgung ein tiefes Verständnis für die zugrundeliegenden Probleme voraus, das, obwohl vorhanden, oftmals nicht berücksichtigt wird.

Die Bekämpfung von Hassrede auf Social-Media-Plattformen ist hierfür ein gutes Beispiel. Tausende Content-Moderator:innen sind rund um die Uhr – oft in Ländern des globalen Südens unter schwierigen Bedingungen und zu niedrigen Löhnen – damit beschäftigt, Inhalte zu überprüfen und gegebenenfalls zu löschen. Dieses System ist stark fehleranfällig und aufwendig. Eine KI-Anwendung, die Hassrede automatisch erkennen kann, könnte diesen Prozess weitaus effizienter gestalten. Der erste Schritt zur Entwicklung solcher Systeme besteht darin, Clickworker mit dem Annotieren von Trainingsdaten zu beauftragen. Diese Menschen treffen – oft nach einer oberflächlichen Einführung – Entscheidungen darüber, welche Inhalte als Hassrede gelten. Die Qualität der KI-Modelle hängt direkt von der Qualität dieser Daten ab.

Um zu evaluieren, wie gut verschiedene KI-Anwendungen zur Erkennung von Hassrede funktionieren, werden von vielen Techniker:innen in diesem Bereich universelle Benchmarks gefordert, um die Programme zu testen. Das klingt zwar sinnvoll, ist jedoch in der Realität ungeeignet. Die Regulierung von Hassrede ist ein komplexes Geflecht aus nationalem und internationalem Recht. Jedes Land hat eigene Definitionen von Hassrede. In Österreich etwa bestehen mehrere Straftatbestände, die bestimmte Extremformen regeln, das Medienrecht sowie das Verbotsgesetz, das nationalsozialistische Wiederbetätigung kriminalisiert, während gleichzeitig das Recht auf freie Meinungsäußerung gewährleistet werden muss.

Die rechtliche Bewertung von Hassrede ist stark kontextabhängig und muss im Einzelfall geprüft werden. Auch Gerichte kommen mitunter in den gleichen Fällen zu unterschiedlichen Entscheidungen, so wurde Österreich schon des Öfteren vom Europäischen Gerichtshof für Menschenrechte wegen überschießender Strafen für beleidigende Aussagen wegen Verletzung des Rechts auf freie Meinungsäußerung verurteilt. Diese komplexe Gesetzeslage wird weiter kombiniert mit den (sich laufend ändernden) AGBs der Plattformen selbst, durch die die Grenzen des Sagbaren mitbestimmt werden.

Wenn Personen, die diese Hintergründe nicht kennen – seien es Clickworker oder Programmierer:innen selbst – die Datensets annotieren, dann tun sie das beispielsweise nach firmeninternen Vorgaben oder nach ihren persönlichen Wertvorstellungen. Der rechtliche Streit darüber, was akzeptable Kommunikation ist, zeigt, dass es in einer demokratischen, und von Vielfalt gekennzeichneten Welt große Unterschiede darüber gibt, was als Grenze des Rechts auf freie Meinungsäußerung gesehen wird, und zwar sowohl unter den Bürger:innen, als auch zwischen Staaten und Plattformen. Sich auf klare Grenzen des Sagbaren und den Schutz dessen, was sagbar bleiben muss, zu einigen, ist die Aufgabe von demokratischen Prozessen. Statt diese vielen Perspektiven miteinzubeziehen, wird ein „aus dem Bauch heraus“ erzeugtes Datenset ein genauso „aus dem Bauch heraus“ generiertes KI-Modell hervorbringen. Um komplexe Regulierungsprobleme zu lösen, ist eine solche KI daher nicht geeignet. In enger Zusammenarbeit mit Expert:innen im Feld von Hassrede, könnte eine solche KI-Anwendung jedoch durchaus nützlich sein, wenn sie eingeschränkte Aufgaben, wie Vorsortierung oder Kennzeichnung von eindeutig verbotener Hassrede, übernimmt und damit die menschlichen Entscheidungen unterstützt.

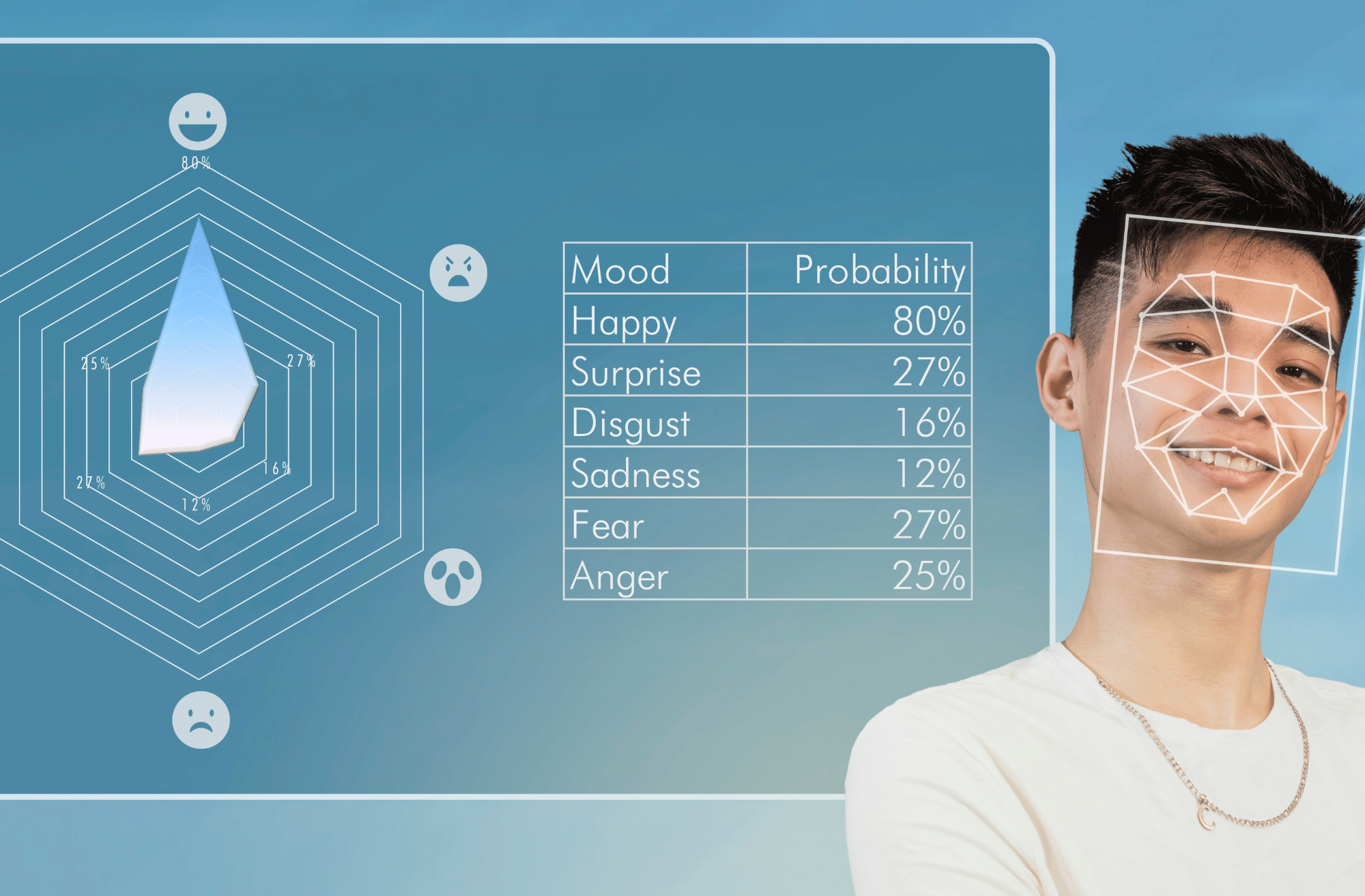

Das Problem der Untauglichkeit von KI für konkrete Problemstellungen verschärft sich dort, wo Programme auf der Basis von Annahmen generiert werden, die von Grund auf umstritten sind. Dies ist beispielsweise der Fall beim Einsatz von Emotionserkennung auf Basis von Gesichtsausdrücken zur Betrugserkennung (also als Lügendetektor) an den EU-Außengrenzen. In den letzten Jahren wurden Forschungsprojekte mit dem Ziel, eine solche Anwendung zu entwickeln, von der EU gefördert.

Die automatische Emotionserkennung beruht auf der Theorie des Psychologen Paul Ekman, nach der universelle Emotionen kulturunabhängig aus dem Gesicht ablesbar seien. Die Psychologin und Neurowissenschaftlerin Lisa Feldman Barrett und ihre Kolleg:innen kommen jedoch nach Durchsicht der einschlägigen empirischen Studien zu dem Ergebnis, dass viele Teile der Theorie Ekmans nicht belegt werden können und, dass wissenschaftliche Befunde dieser sogar widersprechen. Außerdem besteht ein großer Unterschied zwischen den Verhältnissen, in denen die Daten generiert werden, zum Beispiel durch Proband:innen an einer Universität, wo für die teilnehmenden Personen kein Risiko besteht, wenn die „Lüge“ nicht geglaubt wird, und der realen Situation während der Einvernahme an der Grenze, die ohnehin schon massiven Stress auslösen kann, unabhängig davon, ob eine Täuschungsabsicht besteht oder nicht.

Sind die Grundannahmen einer KI-Anwendung falsch, wird diese das Problem, für das sie entwickelt wurde, nicht lösen können. Das heißt: Auch wenn KI noch so gut Gesichtsausdrücke erkennen und kategorisieren kann, würde sie, wenn Gesichtsausdrücke nichts über die Emotion oder die Emotion nichts über Lügen- oder Täuschungsabsicht aussagen, als Lügendetektor versagen. Bei der Entwicklung einer solchen Anwendung müssten also auch die Annahmen, auf denen sie beruht, explizit gemacht und bewiesen werden.

Eine weitere Schwierigkeit stellt die Evaluierung dar. Systeme, die Ergebnisse erzielen, die mit anderen Methoden nicht erzielt werden können, können kaum evaluiert werden. Schließlich kann immer noch nicht nachgewiesen werden, wer gelogen hat und wer nicht. Stützt sich ein Gericht allein oder vor allem auf das Ergebnis eines solchen Lügendetektors, bestätigt es nur dessen Ergebnis. Eine Aussage darüber, ob das Ergebnis korrekt war oder nicht, lässt sich daraus nicht ableiten.

Der wissenschaftliche Standard der Falsifizierbarkeit muss auch für KI gelten. Es sollte einen Mechanismus geben, um festzustellen, ob die KI das Problem der realen Welt, für das sie eingesetzt wird, löst, oder ob ihre Antworten falsch sind. In vielen Bereichen der Vorhersage, wie bei Predictive Policing oder bei Risikovorhersagen gibt es diese Kontrollmöglichkeiten nicht, weil die Tools die Endergebnisse stark beeinflussen und dadurch wie selbsterfüllende Prophezeiungen funktionieren.

Es wird deutlich, dass die Lösungsansätze sich oft an den Fähigkeiten von KI orientieren, anstatt an den Erfordernissen der realen Probleme. Das kann zum Beispiel bedeuten, dass statt der benötigten, die verfügbaren oder leichter zu beschaffenden Daten verwendet werden. Eine sinnvolle Nutzung von KI erfordert eine engere Zusammenarbeit von Entwickler:innen und Wissenschaftler:innen, die Expertise über die Einsatzgebiete der KI haben, seien es Jurist:innen, Sozialwissenschaftler:innen, Psycholog:innen, oder auch Mediziner:innen, Naturwissenschaftler:innen u.a.

Wir müssen achtsam sein, KI nicht für Zwecke einzusetzen, zu denen sie nicht geeignet ist. Die Grundannahmen, auf denen die einzelnen Anwendungen beruhen, müssen überprüfbar und richtig sein. Wir müssen lernen, diese Grenzen des Einsatzes von KI zu erkennen, sowohl in der Entwicklungsphase, als auch bei ihrer Implementierung. Und was KI niemals können wird, ist, Werteentscheidungen, Demokratie und Politik zu ersetzen, ebensowenig wie das Wissen über die Welt, das wir durch wissenschaftliche Verfahren erlangen.

Angelika Adensamer ist Juristin und Kriminologin am Institut VICESSE in Wien. 2024 war sie Digital Humanism Junior Fellow am IWM.